Datysoc prsenta el informe «Fuera de control: uso policial del reconocimiento facial automatizado en Uruguay».Este informe busca aportar elementos para el debate sobre el uso policial del reconocimiento facial automatizado (RFA), explicando aspectos básicos sobre el funcionamiento de esta tecnología y el estado actual de su regulación e implementación en Uruguay.

El informe, como la investigación fueron realizados con el apoyo del Fondo de Respuesta Rápida de Derechos Digitales.

¿Qué es el reconocimiento facial automatizado (RFA)? ¿Por qué genera controversia?

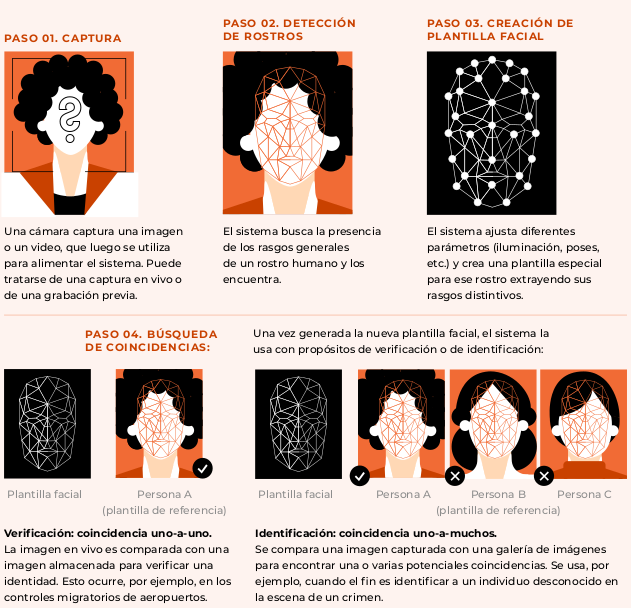

La tecnología de RFA usa imágenes del rostro de una persona y las convierte en una plantilla facial o una representación matemática de la imagen. Luego, un algoritmo puede comparar esa plantilla con una plantilla generada a partir de otra foto. De esta manera, puede determinar el nivel de similitud entre los rostros. El RFA puede incluir funciones de detección, verificación e identificación facial.

Los sistemas de RFA no son infalibles. Hay muchos factores que afectan su precisión: el tipo de algoritmo, los datos que se usan para entrenarlo, la calidad de las imágenes, el contexto en el que se toman, y hasta los distintos tipos de rostros.

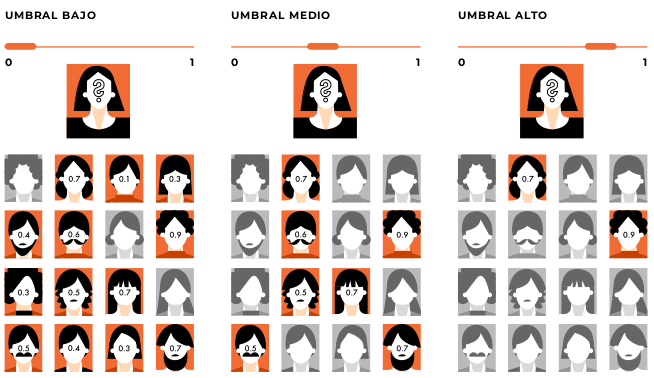

Ningún sistema de RFA puede garantizar la correspondencia perfecta entre dos imágenes de rostros. Los sistemas dan una probabilidad de coincidencia asignando un puntaje de similitud. El administrador del sistema tiene la posibilidad de ajustar el umbral. Si la probabilidad supera un umbral establecido por quien usa el sistema, la coincidencia se acepta (se dice que existe un match).

Resulta evidente la importancia de que quien opera el sistema reciba la formación adecuada por parte de los proveedores o desarrolladores para hacerlo correctamente de acuerdo al contexto y a los diferentes escenarios de uso. Este y otros factores explican la existencia de falsos positivos (declarar que dos imágenes son una coincidencia cuando en realidad son de dos personas diferentes) y/o falsos negativos (declarar que dos imágenes no coinciden cuando en realidad son de la misma persona).

Los sistemas de RFA pueden usarse con distintos fines. Algunos usos en situaciones específicas no generan controversia. Por ejemplo, la verificación de la identidad para el ingreso de personas autorizadas a áreas industriales restringidas. Sin embargo, el RFA se usa en cada vez más contextos: oficinas, aeropuertos, bares e incluso en las calles. Allí, hay muchas variables no controladas, como la iluminación o el ángulo en que se capta el rostro, lo que aumenta la tasa de error del sistema.

Según la US GAO (United States Government Accountability Office), existen problemas serios en el uso actual de sistemas de RFA. Hay problemas de privacidad y seguridad sobre los datos: las personas no tienen control efectivo sobre sus datos biométricos y sobre la información personal asociada a ellos. Hay también problemas en la precisión y el desempeño: los sesgos de los sistemas de RFA pueden perjudicar especialmente a personas con tez oscura, mujeres, niños y niñas, personas adultas mayores y personas trans. Los sistemas de RFA presentan además problemas de opacidad: los datos utilizados para entrenar los algoritmos suelen ser propiedad de empresas y no se comparten con organismos evaluadores ni con el público.

Cada vez más reglamentaciones establecen que los sistemas de RFA deben permitir la supervisión por parte de humanos, quienes tienen la tarea de prevenir o minimizar los riesgos derivados de las posibles deficiencias del algoritmo. Pero, si bien la intervención humana es necesaria, no siempre es suficiente para corregir o advertir errores de desempeño en los algoritmos. Muchas veces la confianza acrítica en las herramientas automatizadas por parte de quienes operan con ellas implica nuevos riesgos.

¿Cuáles son los usos policiales más comunes del reconocimiento facial automatizado? ¿Cómo pueden afectarte?

En los últimos años, el RFA se convirtió en una tecnología “de moda” para la prevención y combate del delito, adquirida por la policía de muchos países. Encontramos que el RFA suele ser usado por la policía:

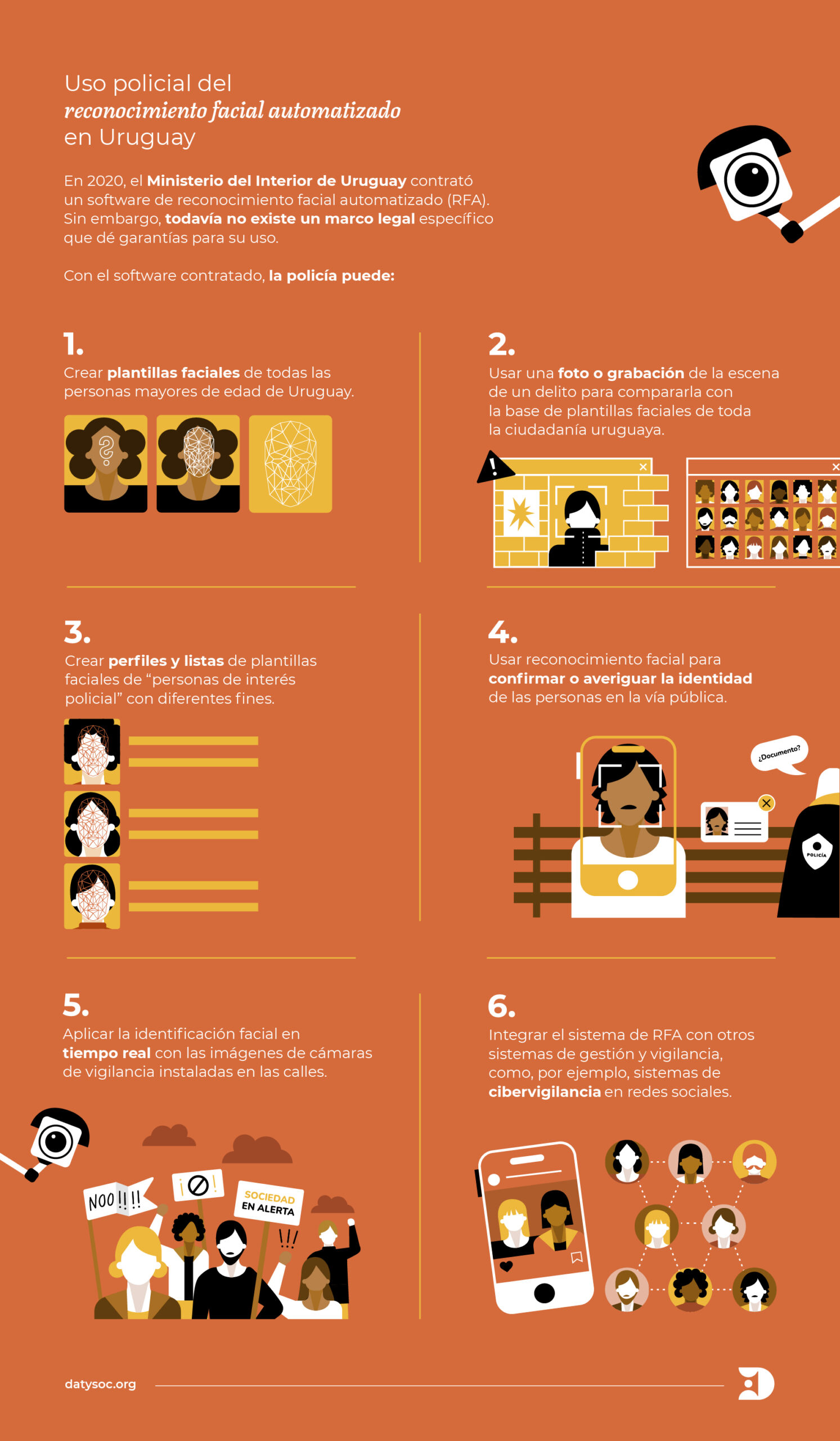

- para confirmar la identidad de personas en un operativo o en tareas de patrullaje,

- para comparar la imagen de una persona sospechosa de un delito con una base de datos de imágenes de personas con antecedentes,

- para averiguar la identidad y vínculos de personas a partir de fotografías publicadas en redes sociales y otros sitios web (cibervigilancia), y

- para identificar en vivo a «personas de interés» en el espacio público utilizando los circuitos cerrados de vigilancia policiales.

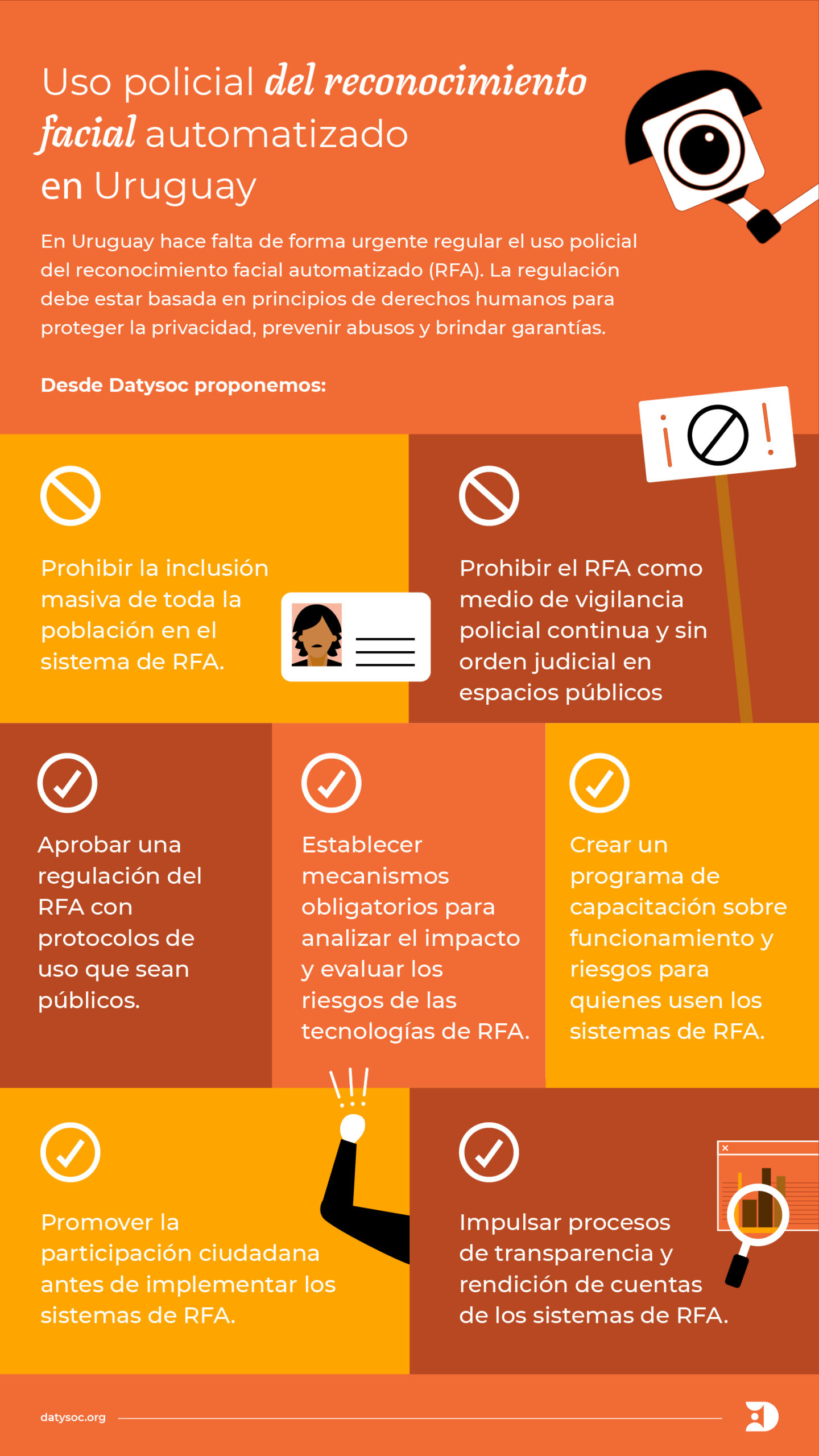

El uso de RFA por la policía es parte de una discusión más amplia: la capacidad cada vez mayor del Estado de recolectar, almacenar y cruzar datos de la ciudadanía y cuáles serán los principios que gobiernen el uso estatal de esos datos. El poder de vigilancia que otorga esta capacidad de uso de datos afecta directamente los derechos de libertad de expresión y la privacidad, así como el derecho de reunión y de protesta. Las medidas de vigilancia, por lo tanto, deben estar autorizadas por una ley, tener un objetivo legítimo, ser estrictamente necesarias y proporcionales. Los Estados tienen la obligación de prevenir la vigilancia masiva, que por definición no cumple con los principios de necesidad y proporcionalidad. La recopilación o migración de datos biométricos de toda la ciudadanía para uso policial es un caso de vigilancia masiva.

El uso policial de RFA trae además muchas preguntas: ¿qué ocurre cuando una persona es identificada erróneamente en una investigación por una falla en el algoritmo? ¿Cómo se decide el margen de error aceptable en un sistema de RFA? ¿La policía puede vigilar preventivamente a todas las personas en los espacios públicos? ¿La policía puede crear todas las listas de personas que desee? En definitiva, ¿cuál es el límite para la vigilancia policial?

En 2019, el Relator Especial sobre la promoción y protección del derecho a la libertad de opinión y de expresión realizó un llamado urgente para la rigurosa regulación de las exportaciones de equipos de vigilancia, la adopción de restricciones más estrictas para su utilización, y solicitó una moratoria inmediata sobre la venta y la transferencia a nivel mundial “hasta que se establezcan estrictas salvaguardas de los derechos humanos en la regulación de esas prácticas y se pueda garantizar que los gobiernos y los agentes no estatales van a utilizar esos instrumentos de un modo legítimo”. Existe suficiente evidencia empírica que apoya las recomendaciones de los organismos de derechos humanos sobre la urgente necesidad de marcos legales específicos y transparentes para esta tecnología. Debido a la gran preocupación por el uso policial de RFA y a varios casos emblemáticos de abuso de estos sistemas, comenzaron a aprobarse regulaciones sobre el tema en varias regiones. Algunas de ellas brindan garantías para prevenir la afectación de derechos fundamentales.

¿Cuál es la situación en Uruguay?

Desde 2010, el Ministerio del Interior empezó a instalar sistemas de monitoreo y cámaras de vigilancia en las calles con el fin de mejorar la estrategia para prevenir el delito y aportar pruebas a la justicia. Actualmente hay casi 9 mil cámaras instaladas en todo el país. Las cámaras de vigilancia se fueron haciendo parte del paisaje de nuestras ciudades. Pero en 2020, con la Ley de Presupuesto, se creó una base de datos de identificación facial para ser usada con fines de seguridad pública.

Artículo 191

Créase en el Inciso 04 “Ministerio del Interior”, Unidad Ejecutora 001 “Secretaría del Ministerio del Interior”, una base de datos de identificación facial para su administración y tratamiento con fines de seguridad pública, en estricto cumplimiento de los cometidos asignados por la Ley N.º 19315, de 18 de febrero de 2015, y a lo dispuesto en la Ley N.º 18331, de 11 de agosto de 2008.

Artículo 192

Autorízase en el Inciso 04 “Ministerio del Interior”, Unidad Ejecutora 031 “Dirección Nacional de Identificación Civil”, la migración actualizada a la Unidad Ejecutora 001 “Secretaría del Ministerio del Interior”, de la totalidad de las imágenes faciales de las personas mayores de edad de las que lleva registro, los nombres y apellidos de sus titulares, sexo, fecha de nacimiento, nacionalidad, número de cédula de identidad, fecha de expedición y fecha de expiración de esta última.

La policía ya había comprado un software de RFA en febrero de 2020 y necesitaba esta reforma legislativa para poder usar todos los datos de rostros en poder de la Dirección Nacional de Identificación Civil para alimentar el software de RFA con fines de vigilancia.

¿Qué puede hacer la policía con el software que contratado?

Los usos descritos en la infografía son usos potenciales que se derivan de la simple lectura de los requisitos mínimos del software que el pliego de licitación exigió cumplir a los oferentes. El Ministerio del Interior aún no ha publicado información relativa al uso efectivo del sistema de RFA ni ha confirmado si se encuentra operativo.

¿Qué información tenemos sobre la implementación del sistema de RFA en el Ministerio del Interior?

La implementación del sistema de RFA para uso de la policía ya está en proceso, aunque en Uruguay no existe ninguna reglamentación específica ni protocolos públicos que brinden garantías para su uso. Esto da a la policía una amplia discrecionalidad que no es compatible con los estándares mínimos de derechos humanos.

De acuerdo con la información obtenida en nuestro informe, al mes de agosto de 2021 el Ministerio del Interior no cumplía con aspectos básicos de protección de datos personales, como el registro de sus bases de uso administrativo en la Unidad Reguladora y de Control de Datos Personales (URCDP) o la designación de un Delegado de Protección de Datos, según indica la ley de protección de datos personales y sus decretos reglamentarios. A su vez, encontramos que, de acuerdo con el artículo 3 de nuestra Ley de Protección de Datos Personales, la URCDP no tiene potestades de supervisión sobre las bases cuyo objeto sea la seguridad pública.

El Ministerio del Interior se niega también a brindar información sobre el sistema de RFA y su implementación, incumpliendo la ley de acceso a la información pública, y tampoco responde las solicitudes de informe parlamentario relacionadas con sus sistemas de seguridad de datos. Hasta donde existe información, aún no se ha realizado una capacitación sobre funcionamiento y riesgos del uso del software de RFA para su personal y los actores del sistema judicial.

En resumen:

- no existe un marco regulatorio que establezca los protocolos de acción, supervisión o auditoría externa sobre el uso del sistema de RFA,

- la URCDP no tiene potestades de supervisión sobre las bases cuyo objeto sea la seguridad pública,

- el Ministerio del Interior no contesta o rechaza las solicitudes de acceso a la información pública, y

- el Ministerio del Interior tampoco responde las solicitudes de informe parlamentario relacionadas con vulneraciones de seguridad a sus sistemas.

¿Qué propone Datysoc?

Si querés conocer más sobre el tema, descargá el informe “Fuera de control: uso policial del reconocimiento facial automatizado en Uruguay”